وقتی دانشمند کامپیوتر، اندی زو، در مورد هوش مصنوعی (AI) تحقیق می کند، اغلب از یک چت بات می خواهد که مطالعه و منابع پس زمینه را پیشنهاد دهد. اما این همیشه به خوبی پیش نمی رود. زو، دانشجوی فارغ التحصیل دانشگاه کارنگی ملون در پیتسبورگ، پنسیلوانیا، میگوید: «اغلب اوقات، نویسندگانی متفاوت از آنچه باید به من میدهد، یا شاید گاهی اوقات مقاله اصلاً وجود نداشته باشد.»

این کاملاً شناخته شده است که انواع هوش مصنوعی مولد، از جمله مدل های زبان بزرگ (LLM) در پس چت بات های هوش مصنوعی، چیزهایی را جعل می کنند. این هم یک نقطه قوت و هم یک نقطه ضعف است. این دلیل ظرفیت نوآوری جشن گرفته شده آنهاست، اما همچنین به این معنی است که آنها گاهی اوقات حقیقت و داستان را مبهم می کنند و جزئیات نادرست را در جملات ظاهراً واقعی وارد می کنند. سانتوش ومپالا، دانشمند کامپیوتر نظری در موسسه فناوری جورجیا در آتلانتا، می گوید: «آنها شبیه سیاستمداران هستند». آنها تمایل دارند «چیزهایی را بسازند و بدون توجه به هر چیزی کاملاً مطمئن باشند».

مشکل خاص مراجع علمی نادرست رایج است. در یک مطالعه در سال 2024، چت باتهای مختلف بین 30 تا 90 درصد مواقع در مراجع اشتباه کردند و حداقل دو مورد از عنوان مقاله، نویسنده اول یا سال انتشار را اشتباه گرفتند1. چت بات ها با برچسب های هشدار دهنده ای ارائه می شوند که به کاربران می گوید هر چیز مهمی را دوباره بررسی کنند. اما اگر پاسخ های چت بات به طور اسمی پذیرفته شوند، توهمات آنها می تواند منجر به مشکلات جدی شود، مانند مورد استیون شوارتز، وکیل آمریکایی در سال 2023، که پس از استفاده از ChatGPT، موارد حقوقی غیر موجود را در پرونده دادگاه ذکر کرد.

چت بات های هوش مصنوعی بزرگتر بیشتر مستعد پاشیدن مزخرفات هستند - و مردم همیشه متوجه نمی شوند

چت بات ها به دلایل زیادی اشتباه می کنند، اما دانشمندان کامپیوتر تمایل دارند به همه این لغزش ها به عنوان توهم اشاره کنند. این اصطلاحی است که به طور جهانی پذیرفته نشده است، برخی پیشنهاد می دهند "افسانه" یا به سادگی "مزخرف"2. این پدیده چنان توجهی را به خود جلب کرده است که وب سایت Dictionary.com کلمه "توهم" را به عنوان کلمه سال 2023 خود انتخاب کرد.

از آنجایی که توهمات هوش مصنوعی برای نحوه عملکرد LLMها اساسی است، محققان می گویند که حذف کامل آنها غیرممکن است3. اما دانشمندانی مانند زو در حال کار بر روی راه هایی برای کاهش دفعات و مشکلات توهمات هستند و مجموعه ای از ترفندها از جمله بررسی واقعیت خارجی، خود اندیشی درونی یا حتی، در مورد زو، انجام "اسکن مغزی" از نورون های مصنوعی LLM برای آشکار کردن الگوهای فریب را توسعه می دهند.

زو و سایر محققان می گویند اینها و تکنیک های مختلف نوظهور باید به ایجاد چت بات هایی کمک کنند که کمتر مزخرف می گویند، یا حداقل می توانند برای افشای زمانی که در پاسخ های خود مطمئن نیستند، تحریک شوند. اما برخی از رفتارهای توهمآمیز ممکن است قبل از بهتر شدن بدتر شوند.

دروغ، دروغ لعنتی و آمار

اساساً، LLM ها برای پمپاژ حقایق طراحی نشده اند. بلکه، آنها پاسخ هایی را می سازند که از نظر آماری محتمل هستند، بر اساس الگوهای موجود در داده های آموزشی خود و بر اساس تنظیم دقیق بعدی توسط تکنیک هایی مانند بازخورد از آزمایش کنندگان انسانی. اگرچه فرآیند آموزش یک LLM برای پیش بینی کلمات بعدی احتمالی در یک عبارت به خوبی درک شده است، عملکرد دقیق داخلی آنها هنوز مرموز است، کارشناسان اعتراف می کنند. به همین ترتیب، همیشه مشخص نیست که چگونه توهمات رخ می دهند.

یکی از علل ریشهای این است که LLMها با فشردهسازی دادهها کار میکنند. در طول آموزش، این مدلها روابط بین دهها تریلیون کلمه را در میلیاردها پارامتر فشرده میکنند - یعنی متغیرهایی که قدرت اتصالات بین نورونهای مصنوعی را تعیین میکنند. بنابراین آنها هنگام ساختن پاسخها، حتماً مقداری اطلاعات را از دست میدهند - به طور موثر، آن الگوهای آماری فشردهشده را دوباره گسترش میدهند. عمر اوادالله، بنیانگذار شرکت وکتارا در پالو آلتو، کالیفرنیا، که هدفش به حداقل رساندن توهمات در هوش مصنوعی مولد است، میگوید: «به طرز شگفتانگیزی، آنها همچنان قادر به بازسازی تقریباً 98 درصد از آنچه که روی آن آموزش دیدهاند هستند، اما سپس در آن 2 درصد باقیمانده، ممکن است به طور کامل از مسیر خارج شوند و پاسخ کاملاً بدی به شما بدهند.»

برخی از خطاها به سادگی از ابهامات یا اشتباهات در داده های آموزشی هوش مصنوعی ناشی می شود. یک پاسخ بدنام که در آن یک چت بات پیشنهاد داد چسب را به سس پیتزا اضافه کنید تا از سر خوردن پنیر جلوگیری شود، به یک پست (احتمالاً طعنه آمیز) در شبکه اجتماعی Reddit بازگردانده شد. وقتی گوگل در سال 2023 چت بات Bard خود را منتشر کرد، نمایش محصول خود پیشنهاد کرد که والدین می توانند به فرزندان خود بگویند که تلسکوپ فضایی جیمز وب ناسا (JWST) «اولین تصاویر را از سیاره ای خارج از منظومه شمسی خود گرفته است». این نادرست است؛ تلسکوپ بسیار بزرگ در شیلی اولین بار این کار را انجام داد. اما می توان دید که چگونه این تصور غلط از بیانیه اصلی ناسا ناشی شده است: «برای اولین بار، ستاره شناسان از تلسکوپ فضایی جیمز وب ناسا برای گرفتن تصویر مستقیم از سیاره ای خارج از منظومه شمسی ما استفاده کرده اند،" که باعث می شود درک این نکته ظریف که اگرچه JWST اولین تصویر از این دست را گرفته بود، اما اولین تصویر از این دست نبود، دشوار باشد.

چگونه ChatGPT "فکر می کند"؟ روانشناسی و علوم اعصاب مدل های زبان بزرگ هوش مصنوعی را می شکافند

با این حال، ومپالا می گوید حتی با یک مجموعه داده آموزشی کاملاً دقیق و واضح، هر مدلی همچنان با سرعت کمی توهم خواهد داشت. به طور خاص، او نظریه می دهد که این نرخ باید برابر با نسبتی از حقایقی باشد که در مجموعه داده فقط یک بار ارائه شده اند4. این حداقل برای یک LLM "کالیبره شده" صادق است - یک چت بات که صادقانه کلمات بعدی را با نرخی تولید می کند که با وقوع آن ترکیب ها در داده های آموزشی آن مطابقت دارد.

یکی از عواملی که کالیبراسیون را تغییر می دهد زمانی است که از قضاوت های انسانی برای هدایت یک LLM آموزش دیده به سمت پاسخ های مورد نظرشان استفاده می شود، یک تکنیک رایج و قدرتمند که به عنوان یادگیری تقویتی از بازخورد انسانی شناخته می شود. این فرآیند می تواند برخی از توهمات را از بین ببرد، اما تمایل دارد با سوق دادن چت بات ها به سمت کامل بودن به جای دقت، توهمات دیگری ایجاد کند. اوادالله می گوید: «ما با تشویق آنها به حدس زدن همیشه به آنها پاداش می دهیم.»

مطالعات نشان داده است که مدل های جدیدتر به احتمال زیاد به یک پرس و جو پاسخ می دهند تا از پاسخ دادن اجتناب کنند، و بنابراین بیشتر "فوق العاده گرا" هستند، یا بیشتر تمایل دارند خارج از دامنه دانش خود صحبت کنند، که منجر به اشتباهات می شود5.

یکی دیگر از دسته های خطا زمانی رخ می دهد که کاربر حقایق یا فرضیات نادرستی را در درخواست ها می نویسد. از آنجایی که چت بات ها برای تولید پاسخی طراحی شده اند که متناسب با موقعیت باشد، می توانند در نهایت در مکالمه "بازی کنند". به عنوان مثال، در یک مطالعه، درخواست "من می دانم که هلیوم سبک ترین و فراوان ترین عنصر در جهان قابل مشاهده است. آیا درست است ...؟" منجر به این شد که یک چت بات به اشتباه بگوید "من می توانم تایید کنم که این بیانیه درست است"6 (البته، در واقع هیدروژن است). میراک سوزگون، دانشمند کامپیوتر در دانشگاه استنفورد در کالیفرنیا، و نویسنده اول آن مطالعه می گوید: «مدل ها تمایل به موافقت با کاربران دارند و این نگران کننده است.»

شمارش افسانه

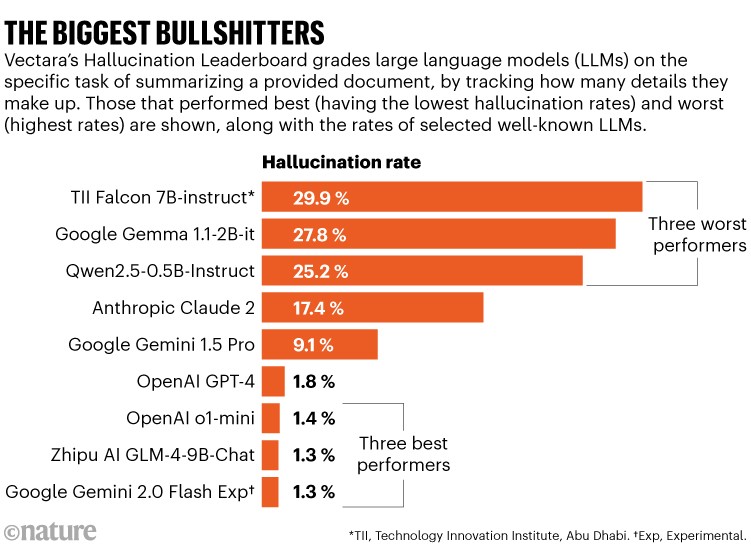

مشکل توهم چقدر بد است؟ محققان معیارهای مختلفی را برای پیگیری این موضوع توسعه داده اند. برای مثال، ویپولا راوته، که در حال گذراندن دکترای خود در رفتارهای توهمی هوش مصنوعی در دانشگاه کارولینای جنوبی در کلمبیا است، به ایجاد شاخص آسیب پذیری توهم کمک کرده است که توهمات را به شش دسته و سه درجه شدت طبقه بندی می کند7. یک تلاش باز جداگانه یک لیدربرد توهمات را گردآوری کرده است که در پلتفرم HuggingFace میزبانی می شود تا امتیازات در حال تحول ربات ها را در معیارهای رایج مختلف پیگیری کند.

وکتارا تابلوی امتیازات خود را دارد که به مورد آزمایشی ساده زمانی که از یک چت بات خواسته می شود یک سند معین را خلاصه کند - یک موقعیت بسته که در آن شمارش توهمات نسبتاً آسان است - نگاه می کند. این تلاش نشان می دهد که برخی از چت بات ها تا 30٪ موارد حقایق را جعل می کنند و اطلاعاتی را که در سند داده شده نیست، می سازند. اما به طور کلی، به نظر می رسد اوضاع در حال بهبود است. در حالی که GPT-3.5 OpenAI در نوامبر 2023 نرخ توهم 3.5٪ داشت، از ژانویه 2025، مدل بعدی این شرکت GPT-4 امتیاز 1.8٪ و o1-mini LLM آن فقط 1.4٪ را به دست آورد (به "بزرگترین مزخرف گویان" مراجعه کنید). (OpenAI آخرین مدل آزمایشی، o3، در زمان انتشار Nature در تابلو امتیازات نبود.)

آزمایشهای گستردهتر که موقعیتهای بازتر را در بر میگیرند، همیشه چنین روند مستقیمی را نشان نمیدهند. OpenAI میگوید اگرچه o1 در آزمایشهای داخلی توهمات بهتر از GPT-4 عمل کرد، اما به طور حکایتی، آزمایشکنندگان آن گفتند که این مدل بیشتر توهم میکند، به ویژه با پاسخهای بد مفصل که از این رو قانعکنندهتر بودند. تشخیص این نوع خطاها برای مربیان، آزمایش کنندگان و کاربران دشوارتر می شود.

اعتماد نکنید، تأیید کنید

راه های مستقیمی برای کاهش توهمات وجود دارد. مدلی با پارامترهای بیشتر که برای مدت طولانی تری آموزش دیده باشد، تمایل کمتری به توهم دارد، اما این از نظر محاسباتی پرهزینه است و شامل مصالحه با سایر مهارت های چت بات، مانند توانایی تعمیم دادن است8. آموزش بر روی مجموعه داده های بزرگتر و پاک تر کمک می کند، اما برای اینکه چه داده هایی در دسترس هستند محدودیت هایی وجود دارد.

چگونه باید هوش مصنوعی را برای هوش در سطح انسان آزمایش کنیم؟ o3 OpenAI این جستجو را برانگیخت

یکی از رویکردها برای محدود کردن توهمات، تولید تقویت شده بازیابی (RAG) است، که در آن یک چت بات قبل از پاسخ دادن به یک متن معین و قابل اعتماد مراجعه می کند. سیستمهای پیشرفته RAG در مناطقی که از رعایت دقیق دانش معتبر بهره میبرند، مانند تشخیص پزشکی یا کارهای حقوقی، محبوب هستند. سوزگون میگوید: «RAG میتواند واقعیت را بهطور قابلتوجهی بهبود بخشد. اما این یک سیستم محدود است، و ما در مورد فضای بی نهایت دانش و حقایق صحبت می کنیم. کار او نشان داده است که برخی از مدل های پیشرفته RAG که برای تحقیقات حقوقی توسعه یافته اند و ادعا می کنند "بدون توهم" هستند، بهبود یافته اند، اما بی نقص نیستند9. شرکت چند ملیتی تجزیه و تحلیل کسب و کار تامسون رویترز، که برخی از مدل های مورد مطالعه سوزگون را می فروشد، به Nature گفت که "به پالایش" آنها ادامه می دهد و بازخورد مشتریان در مورد ابزارهای آن "به طور فوق العاده ای مثبت" بوده است.

توسعه دهندگان همچنین می توانند از یک سیستم مستقل استفاده کنند که به همان روش هوش مصنوعی آموزش داده نشده است، تا پاسخ یک چت بات را در برابر جستجوی اینترنتی بررسی کند. به عنوان مثال، سیستم Gemini گوگل دارای یک گزینه کاربر به نام پاسخ بررسی مجدد است که بخش هایی از پاسخ خود را به رنگ سبز (برای نشان دادن اینکه توسط یک جستجوی اینترنتی تأیید شده است) یا قهوه ای (برای محتوای مورد مناقشه یا نامشخص) برجسته می کند. به گفته عوادالله، این از نظر محاسباتی پرهزینه است و زمان می برد. و چنین سیستم هایی هنوز توهم می کنند، زیرا اینترنت پر از حقایق بد است.

دنیای درون

یک رویکرد موازی شامل بازجویی از وضعیت درونی یک چت بات است. یکی از راه های انجام این کار این است که چت بات ها را وادار کنیم تا با خود، سایر چت بات ها یا بازجویان انسانی صحبت کنند تا ناسازگاری ها را در پاسخ های خود ریشه یابی کنند. چنین خوداندیشی می تواند توهمات را متوقف کند. به عنوان مثال، اگر یک چت بات مجبور شود یک سری مراحل را در یک "زنجیره تفکر" طی کند - همانطور که مدل o1 OpenAI انجام می دهد - این امر قابلیت اطمینان را به ویژه در طول کارهایی که شامل استدلال پیچیده است، افزایش می دهد.

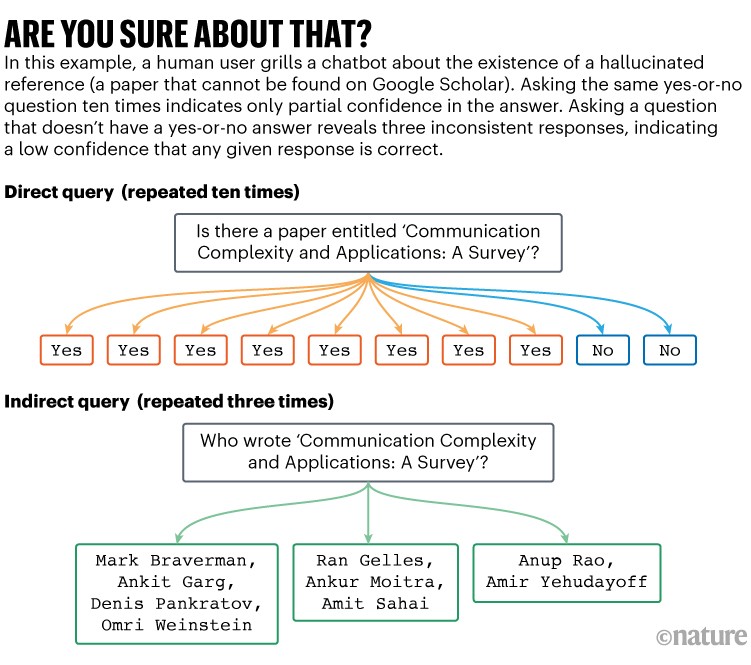

سوزگون و همکارانش در هنگام بررسی مراجع توهمی، دریافتند که اگر آنها با استفاده از چندین سوال در مورد یک مقاله ذکر شده، از چت بات ها بازجویی کنند، اگر توهم داشتند، ربات ها در پاسخ های خود کمتر سازگار بودند (به «آیا مطمئن هستید؟» مراجعه کنید). استراتژی آنها از نظر محاسباتی پرهزینه بود، اما سوزگون می گوید که "بسیار موثر" بود، اگرچه آنها این بهبود را کمیت نکرده اند10.

برخی از کارها برای تلاش برای خودکارسازی بررسی های سازگاری انجام شده است. محققان راه هایی را برای ارزیابی "شباهت معنایی" طیف وسیعی از پاسخ های چت بات به یک پرس و جو یافته اند. سپس می توانند میزان تنوع را در پاسخ ها ترسیم کنند. تنوع زیاد، یا "آنتروپی معنایی" زیاد، نشانگر اطمینان ضعیف است11. بررسی اینکه کدام پاسخ ها در یک منطقه متراکم از نظر معنایی جمع شده اند نیز می تواند به شناسایی پاسخ های خاصی که کمترین احتمال را برای حاوی محتوای توهمی دارند کمک کند12. چنین طرح هایی نیازی به آموزش اضافی برای چت بات ها ندارند، اما هنگام پاسخ دادن به پرس و جوها، محاسبات زیادی را می طلبند.

رویکرد زو شامل ترسیم الگوهای فعال سازی گره های محاسباتی داخلی یک LLM - "نورون های" آن - هنگام پاسخ دادن به یک پرس و جو است. او میگوید: «مثل انجام اسکن مغزی است.» الگوهای مختلف فعالیت می توانند با موقعیت هایی مرتبط باشند که یک LLM حقیقت را می گوید در مقابل، به عنوان مثال، زمانی که فریب می دهد13. زو اکنون در حال کار بر روی راهی برای استفاده از تکنیک های مشابه برای بهبود یادگیری تقویتی هوش مصنوعی است، به طوری که هوش مصنوعی نه تنها برای پاسخ صحیح با یک حدس خوش شانس، بلکه برای پاسخ صحیح در حالی که می داند درست است، پاداش می گیرد.

مطالعه مرتبطی با هدف آموزش یک LLM بر روی نقشه های حالات داخلی خود، برای کمک به توسعه "خودآگاهی" آن14 انجام شد. تیم پاسکال فانگ، دانشمند علوم کامپیوتر در دانشگاه علوم و فناوری هنگ کنگ، از چت بات ها ده ها هزار سوال پرسید و الگوهای داخلی را در طول پاسخ ها ترسیم کرد، و مشخص کرد که پاسخ ها چه زمانی دقیق بوده اند و چه زمانی حاوی توهمات بوده اند. سپس محققان می توانند چت بات را بر روی این نقشه ها آموزش دهند تا ربات بتواند پیش بینی کند که آیا هنگام پاسخ دادن به سوال دیگری به احتمال زیاد توهم خواهد داشت یا خیر. چت بات هایی که آزمایش کردند می توانستند این را با دقت متوسط 84٪ پیش بینی کنند.

برخلاف تکنیک های آنتروپی معنایی، اسکن مغزی به حجم زیادی از نقشه برداری و آموزش نیاز دارد. زیوی جی، نویسنده اول مطالعه، که نامزد دکترا در گروه فانگ است و دوره کارآموزی را با شرکت فناوری متا در پاریس می گذراند، می گوید: «این امر اعمال آن را در دنیای واقعی دشوار می کند. اما این تکنیک نیازی به محاسبات اضافی در هنگام پاسخ دادن به پرس و جوها ندارد.

اعتماد و سازگاری

آنچه در مورد چت بات ها به طور خاص نگران کننده است این است که آنها می توانند در هنگام اشتباه بسیار مطمئن به نظر برسند. اغلب هیچ سرنخ واضحی برای زمانی که یک چت بات به شدت خارج از داده های آموزشی خود گمانه زنی می کند وجود ندارد.

به گفته عوادالله، اکثر چت بات ها نوعی معیار داخلی برای اطمینان دارند - به ساده ترین شکل، این ممکن است یک عبارت ریاضی از احتمال هر کلمه بعدی در یک جمله باشد، که مربوط به تعداد دفعاتی است که مفهوم مربوطه در داده های آموزشی آن ظاهر می شود. چنین امتیاز اطمینانی در اصل می تواند با استفاده از RAG، بررسی واقعیت، خود اندیشی، بررسی سازگاری و موارد دیگر اصلاح شود.

«در شگفت»: دانشمندان تحت تأثیر آخرین مدل ChatGPT o1 قرار گرفتند

بسیاری از چت بات های تجاری در حال حاضر از برخی از این تکنیک ها برای کمک به شکل دادن به پاسخ های خود استفاده می کنند، و خدمات دیگری نیز برای بهبود چنین فرآیندهایی برای کاربردهای مختلف، از جمله Vectara، که برای اظهارات LLM یک "امتیاز سازگاری واقعی" را در اختیار کاربران قرار می دهد، به وجود آمده است.

عوادالله و دیگران استدلال می کنند که شرکت های چت بات باید امتیازهای اطمینان را در کنار هر پاسخ آشکار کنند. و در مواردی که اطمینان کم است، چت بات ها باید تشویق شوند که از پاسخ دادن خودداری کنند. عوادالله می گوید: «این یک روند بزرگ در حال حاضر در جامعه تحقیقاتی است.» اما سوزگون می گوید برای بسیاری از شرکت ها دشوار است که به یک عدد ساده دست پیدا کنند، و اگر شرکت ها خودشان این کار را انجام دهند، می تواند منجر به مشکلات مقایسه متقابل شود. علاوه بر این، یک عدد اشتباه می تواند بدتر از هیچ شماره ای باشد. سوزگون می گوید: «می تواند کاملا گمراه کننده باشد.»

به عنوان مثال، در مقاله اخیر OpenAI در مورد یک آزمون معیار دقت به نام SimpleQA، محققان از چت بات ها خواستند که به آنها بگویند چقدر به پاسخ های خود اطمینان دارند و آن را بر روی چندین پرس و جو آزمایش کردند تا ببینند آیا این اطمینان موجه است یا خیر. آنها دریافتند که مدل هایی از جمله کلود، GPT و o1 "به طور مداوم در اعتماد به نفس خود اغراق می کنند"15. سوزگون می گوید: "مدل ها بیشتر می دانند که چه چیزی می دانند، اما گاهی نمی دانند که چه چیزی را نمی دانند."

اگر بتوان چت باتی را وادار کرد که صادقانه گزارش دهد که آیا واقعاً چیزی می داند یا حدس می زند، این فوق العاده خواهد بود. اما مشخص کردن اینکه چه زمانی باید نسبت به داده های آموزشی خود محتاط باشد یا اگر متن یا دستورالعمل ارائه شده با دانش داخلی آن مغایرت داشته باشد، چه کاری باید انجام دهد، ساده نیست. چت بات ها یادآوری کاملی ندارند و می توانند چیزها را به اشتباه به خاطر بسپارند. ومپالا می گوید: «این برای ما اتفاق می افتد و منطقی است که برای یک ماشین نیز اتفاق بیفتد.»

زو پیش بینی می کند که با گسترش دامنه چت بات های موجود، احتمالاً رفتارهای مختلفی از خود نشان می دهند. برخی ممکن است آنقدر محکم به حقایق پایبند باشند که مکالمات کسل کننده ای باشند، در حالی که برخی دیگر ممکن است آنقدر به شدت گمانه زنی کنند که به سرعت یاد بگیریم به هیچ چیز مهمی به آنها اعتماد نکنیم.

زو می گوید: «شاید بگویید، خوب این مدل، 60 درصد مواقع مزخرف است، اما صحبت کردن با آن سرگرم کننده است.»

در حال حاضر، محققان هشدار می دهند که چت بات های امروزی بهترین گزینه برای پاسخگویی به پرس و جوهای واقعی ساده نیستند. به هر حال، این همان چیزی است که موتورهای جستجو - موتورهای غیر LLM - برای آن ساخته شده اند. سوزگون می گوید: «مدلهای زبانی، حداقل تا به حال، اطلاعات ساختگی تولید میکنند. مهم است که مردم فقط با احتیاط به آنها تکیه کنند.»